大阪国際工科専門職大学 情報工学科3年 AI戦略コース:矢野琉空

はじめまして。大阪国際工科専門職大学 情報工学科3年生の矢野琉空と申します。AI戦略コースに所属し、日々最新技術の習得に励んでいます。本記事では、ChatGPTのVision Fine-Tuning技術を活用し、産業用ロボットの制御に挑戦したプロジェクトについてまとめています。どうぞご覧いただければ幸いです。

1. 実習のテーマと背景

近年、AIとロボットの融合は多くの分野で注目されており、ChatGPTのような大規模言語モデル(LLM)が産業用ロボットの制御に役立つ可能性も広がっています。私はスリーアップ・テクノロジーでの実習を通して、この最先端技術に触れる機会を得ました。

大学でAIを学ぶ中で、AIの可能性には常に魅力を感じており、今回の実習ではChatGPT APIを活用してロボットに指示を出し、実際にロボットアームでオブジェクトを掴むといった操作に挑戦することをテーマにしました。

2. 実習の具体的な取り組みと技術の概要

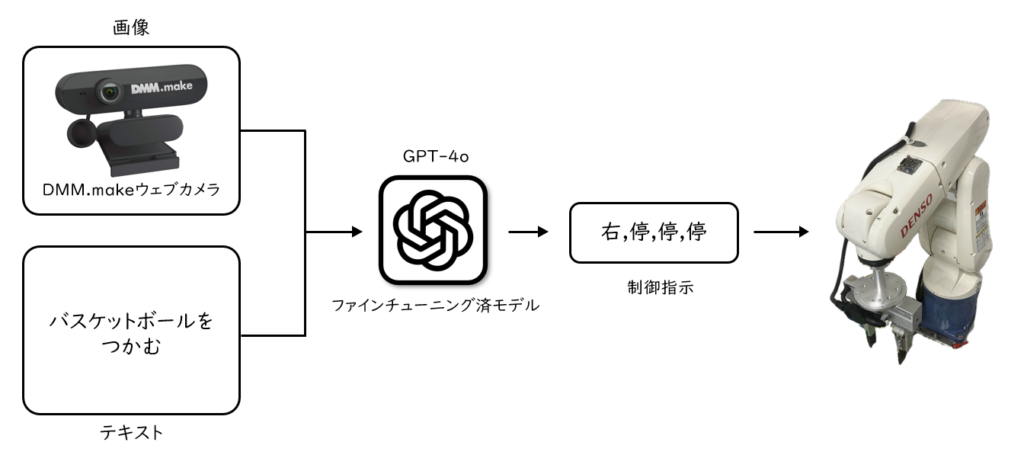

システム構成図

このシステムでは、ウェブカメラで撮影した画像と「バスケットボールをつかむ」というテキストを、ファインチューニング済みのGPT-4oモデルに入力します。このモデルは、画像とテキストの情報を解析し、ロボットに適した制御指示を出力します。この指示に基づいてDENSOロボットが動作するという仕組みです。

Vision Fine-Tuningでモデルを作成

Vision Fine-TuningとはOpenAIが2024年10月1日に公開した機能で、テキストや画像を使用してGPT-4oにファインチューニングを行えるようになりました。この機能により、GPT-4oはテキストだけでなく画像データをもとにした学習が可能になり、視覚情報とテキスト情報を統合してより高度な認識や判断が求められるタスクへの適用が可能となりました。

デモ動画

3. 実習での成果と課題

実習を通じて、ロボットがChatGPTの動作指示に従ってバスケットボールを掴むことはできましたが、安定して掴むことはできませんでした。環境の光加減や物体の位置によって、モデルが正確な指示を出せないことが判明しました。これにより、ロボット制御で安定したパフォーマンスを引き出すには、Vision Fine-Tuningの学習精度向上が必要であることを学びました。

4. ChatGPTによるロボット制御の可能性と今後の展望

今回の実習を通じて、ChatGPTやLLMによるロボット制御の可能性に大きな可能性を感じました。従来はセンサー技術とプログラムが主流でしたが、今では自然言語を使った制御が視野に入り、より柔軟な操作が可能となっています。たとえば、工場のライン作業において、作業者が音声で指示を出し、LLMがその指示を適切なロボット操作に変換することで、作業効率がさらに向上する可能性が考えられます。

一方で、現時点でのLLMのロボット制御には限界も多く、特にリアルタイムでの反応速度や環境の変化に対する適応力には改善の余地があると感じました。今後は、AIモデルの改善や新たな技術の組み合わせによって、より精度の高い制御システムの実現が期待されます。

5. 実習を通じて得た知見と感想

今回の実習を通じて、AIとロボットの融合が産業分野で持つ可能性と、その実現にはまだ克服すべき課題が多いことを理解しました。特に、AIモデルを制御システムに統合するためには、単なるモデル構築にとどまらず、環境に応じたデータ収集やシステム全体の調整が重要であることを学びました。

この実習を通じて得た技術と知見は、今後のキャリアにおいて大いに役立つと確信しています。今後も学びを重ね、成長し続けたいと思います。